Kann künstliche Intelligenz gefährlich werden?

Ein Computer ist erstaunlich dumm. Wir als User nehmen sie zwar als sehr schlau wahr, das ist aber geschickten Programmierern zu verdanken. Tippen wir in unser Navigationssystem eine Adresse ein, dann findet der kleine Computer den besten Weg innerhalb von Sekunden. Toll! Wenn man aber selbst gute Ortskenntnisse hat, dann fällt sofort auf, dass das Navigationssystem nach ganz anderen Regeln navigiert, als man das selbst getan hätte. Raus aus den kleinen Straßen, auf den größten Straßen bis in die Nähe des Ziels und dann den kürzesten Weg über kleinere Straßen. Selbst wäre man wohl ganz anders gefahren und hätte auf Situationen, wie Baustellen, Berufsverkehr usw. reagiert. Das Navi ist also relativ dumm. Was aber ist dann künstliche Intelligenz und kann sie gefährlich werden?

Was ist Intelligenz?

Wer viel weiß muss nicht zwangsläufig intelligent sein. Zwar geht das oft Hand in Hand, aber es ist auch möglich, Tonnen an Informationen auswendig zu lernen und nicht intelligent zu sein. Intelligenz ist die Kunst, neue Informationen zu erzeugen. Man vernetzt die Informationen die man hat und schafft daraus eine neue Information. Denken Menschen, wie der verstorbene Steven Hawkins über schwarze Löcher nach, dann arbeiten sie mit dem spärlichen Wissen, das wir darüber haben. Sie ziehen Rückschlüsse und kommen zu einem Schluss, der sich aus allen verfügbaren Informationen ergibt. Eine große Leistung, die ein Computer nicht erbringen kann.

Kontrollstrukturen

In einem Computerprogramm gibt es, stark vereinfacht gesprochen Input, Algorithmen und Output. Der Input kommt vom User, aus einer Datenbank, oder von einer angeschlossenen Hardware, wie etwa einer Kamera. Der Output ist das Ergebnis, das irgendwohin, etwa auf den Bildschirm, oder an einen Drucker, ausgegeben wird. Dazwischen ist der eigentliche Programmablauf. Der Algorithmus arbeitet mit Kontrollstrukturen. Mit Anweisungen, wie etwa Wenn-dann werden Werte geprüft und abhängig davon weitere Schritte gesetzt. Im Prinzip sorgen diese Kontrollstrukturen dafür, dass das Programm durchläuft und im besten Fall bis zum Output kommt. Fehlertoleranz muss der Programmierer berücksichtigen. Will er etwa eine Rechnung durchführen, dann darf er nicht einfach a mal b rechnen. Er muss prüfen, ob a und b numerische Werte sind. Ist eines davon kein solcher Wert, dann muss eine Fehlermeldung ausgegeben werden, oder ein defaultwert ersetzt den unbrauchbaren Input. Das Programm macht immer dasselbe. Der gleiche Input ergibt den gleichen Output. Zu 100%.

Künstliche Intelligenz

Das Prinzip der künstlichen Intelligenz verlässt die Denkweise des klassischen Algorithmus. Man schafft ein Programm, das nicht nach starren Regeln arbeitet, sondern seine Regeln dynamisch selbst gestaltet und adaptiert. So wird ein Programm viel leistungsfähiger, kann lernen, dass etwas nicht funktioniert hat und es beim nächsten mal besser machen. Eine verlockende Vision. Man braucht nicht für jede Programmänderung einen Programmierer, sondern kann der künstlichen Intelligenz feedback geben, das sie dazu verwendet, ihren Ablauf zu ändern.

Gefahr

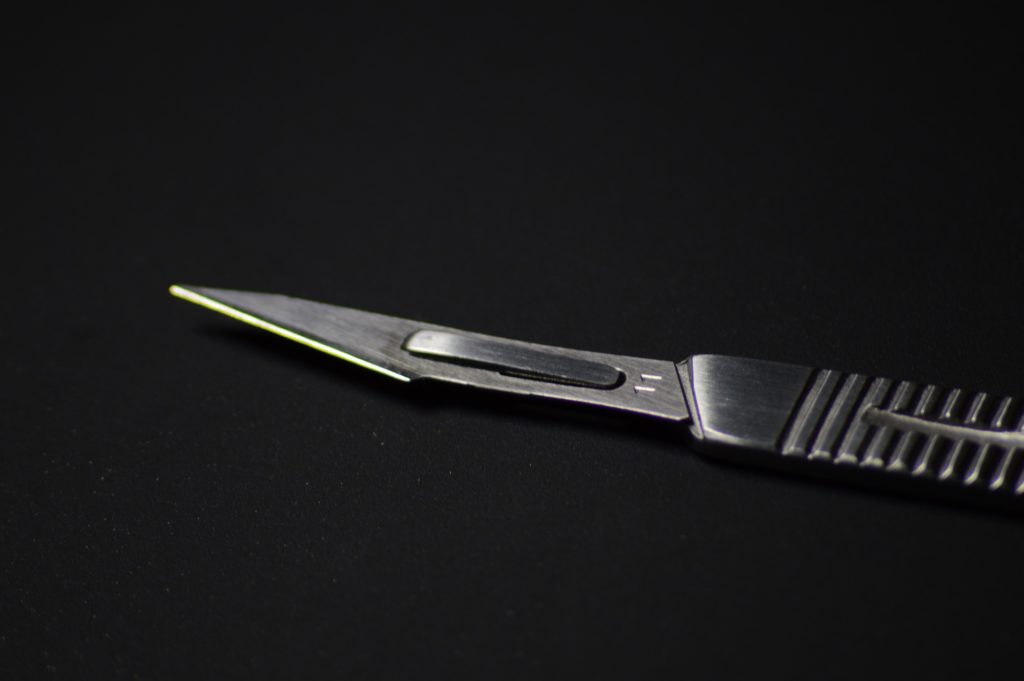

Ein Computerprogramm ist im Regelfall harmlos. Gut, es kann sensible Daten löschen, oder ins Internet hochladen. Aber als Anwender muss man vor dem Bildschirm nicht um Leib und Leben fürchten. Anders sieht das aus, wenn die künstliche Intelligenz Hardware steuert und etwa ein Skalpell in die Roboterhand bekommt. Ist man eines Tages so weit, dass eine künstliche Intelligenz einen chirurgischen Eingriff steuert, dann ist die Gefahr akut. Entscheidet das Programm eigenmächtig etwa, dass eine Operation nicht erfolgreich sein wird, kann es sich weigern. Fehlt die menschliche Kontrolle, oder eine Kontrollinstanz im Programm, bzw. dem neuronalen Netz, das die KI steuert, kann das fatale Folgen haben. Auch wenn man einer solchen Intelligenz die Macht über Waffen gibt, kann eine falsche Entscheidung tödliche Folgen haben. Aus Sicht der Maschine mag die Entscheidung logisch sein, aber Diplomatie, Menschlickeit, Mitleid und viele andere Formen unlogischen Verhaltens ist für unser Zusammenleben essentiell.

Oberste Direktive

Science Fiction Filme sind mit dem Thema künstliche Intelligenz schon lange auf Tuchfüllung. HAL 9000 aus 2001: Odysse im Weltraum ist eine solche künstliche Intelligenz. Aber auch I Robot, oder der Film AI setzen sich mit dem Thema auseinander. Robocop zeigt deutlich einen Mechanismus, der bei einer künstlichen Intelligenz wichtig ist. In kritischen Fällen greift ein übergeordnetes Regelwerk, das üblicherweise, glaubt man den Science Fiction Filmen, dafür sorgt, dass Menschen niemals verletzt werden. Künstliche Intelligenz ist ein weites und faszinierendes Forschungsgebiet. In vielerlei Hinsicht sind Maschinen den Menschen überlegen. Schafft man es, ihnen die Kreativität beizubringen, kann das die Menschheit weiterbringen. Genauso kann es die Menschheit aber auch an ihr Ende bringen.

Regelungen nötig

Elon Musk, der Tesla und Space-X Gründer warnt immer wieder eindringlich vor der Gefahr der künstlichen Intelligenz. Er fordert Regeln und Gesetze, die Entwicklung und Betrieg regeln und sicherstellen, dass nicht jeder seine eigene künstliche Intelligenz schafft. Unter bestimmten Umständen kann künstliche Intelligenz gefährlich werden. Kommunikation unter Maschinen, die der Mensch nicht steuert, Zugriff auf Hardware und das Fehlen von wichtigen Sperren und Limits kann zu einem Problem werden. Ist die Maschine groß genug kann man schnell in die Situation kommen, dass man sie auch nicht mehr abschalten kann. Ist das Rechenzentrum autonom, hat der Rechner Zugriff auf das Zutrittssystem und kann beispielsweise mit der künstlichen Intelligenz beim Energieversorger kommunizieren kann ein Horror Szenario schnell Realität werden.